0.はじめに

ローカルPCにDockerDesktopを入れ、ollamaをopen-webuiで動かす方法です。

Docker:アプリケーションとその実行に必要な環境を「コンテナ」としてパッケージ化し、開発・配布・実行を効率化するプラットフォーム

ollama:規模言語モデル (LLM) をローカルマシン上で簡単に実行・管理できるオープンソースのプラットフォーム

open-webui:ローカル環境で大規模言語モデル (LLM) を実行・管理するためのオープンソースのWebインターフェース(GUI)

23ステップありますので、根気よくついてきてください!

1.DockerDesktopのダウンロードしてインストール

https://www.docker.com/ja-jp/products/docker-desktop

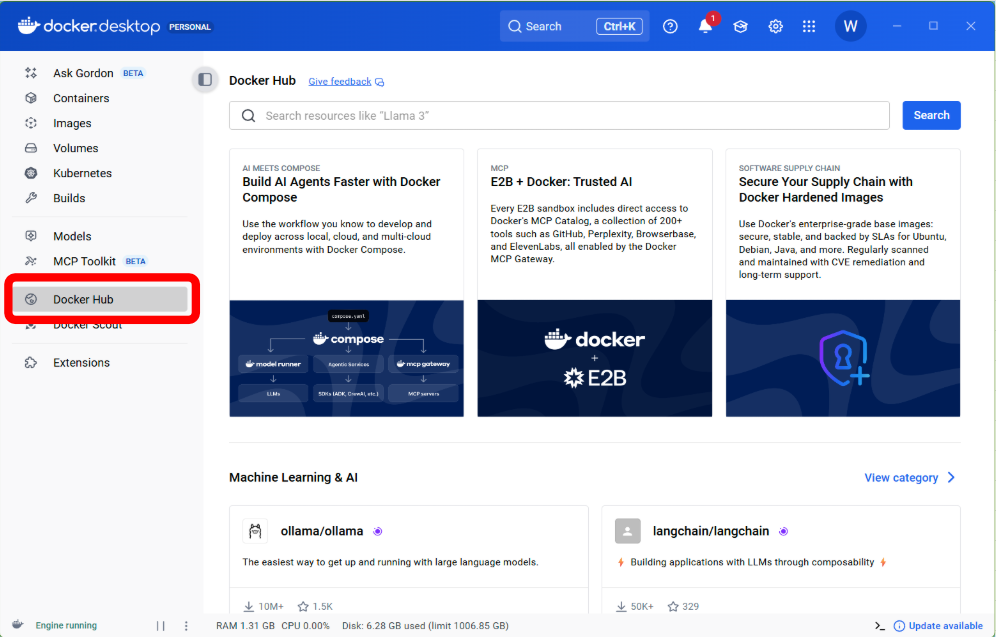

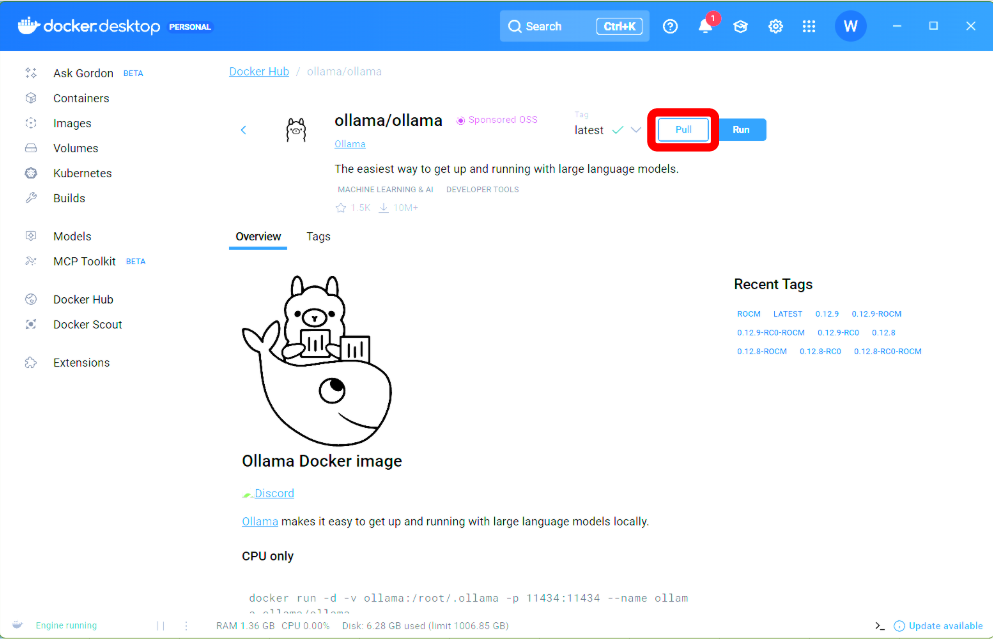

2.DockerDesktopを起動したら、DockerHubを選択

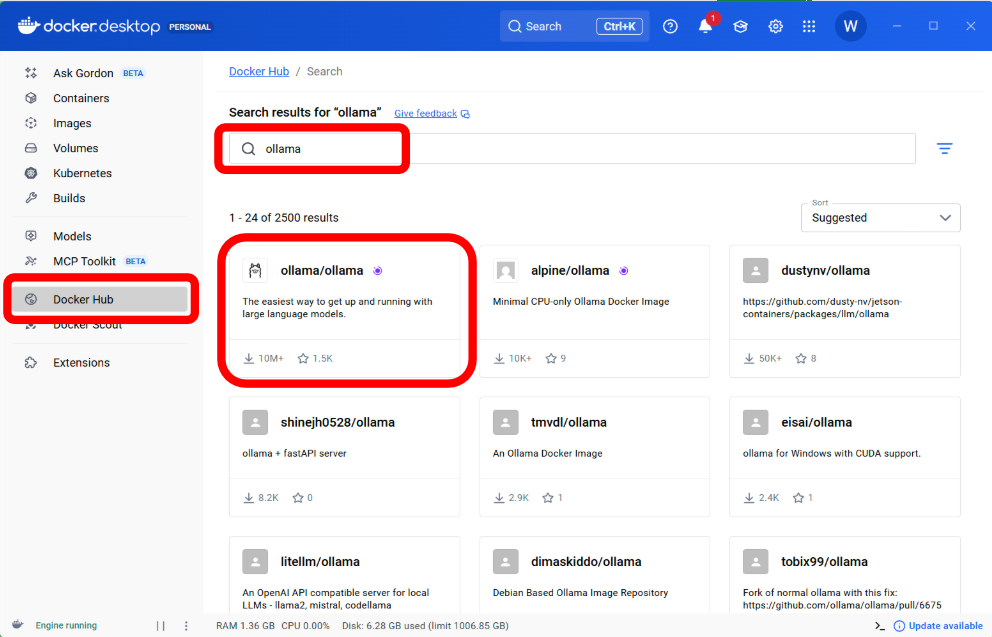

3.検索ボックスに「ollama」を入力して検索

候補に出てきた「ollama/ollama」を選択

4.画面右上の「Pull」を選択

5.4が終わったら、

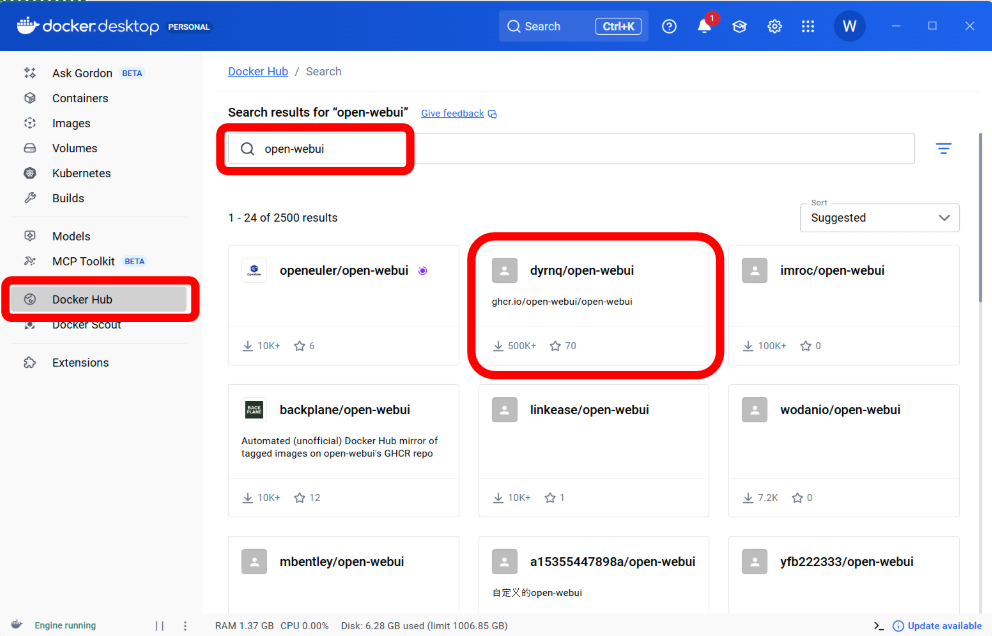

検索ボックスに「open-webui」を入力して検索

候補に出てきた「dyrnq/open-webui」を選択

※open-webuiの候補がいくつがあるが、筆者の実績があるものを選択しています

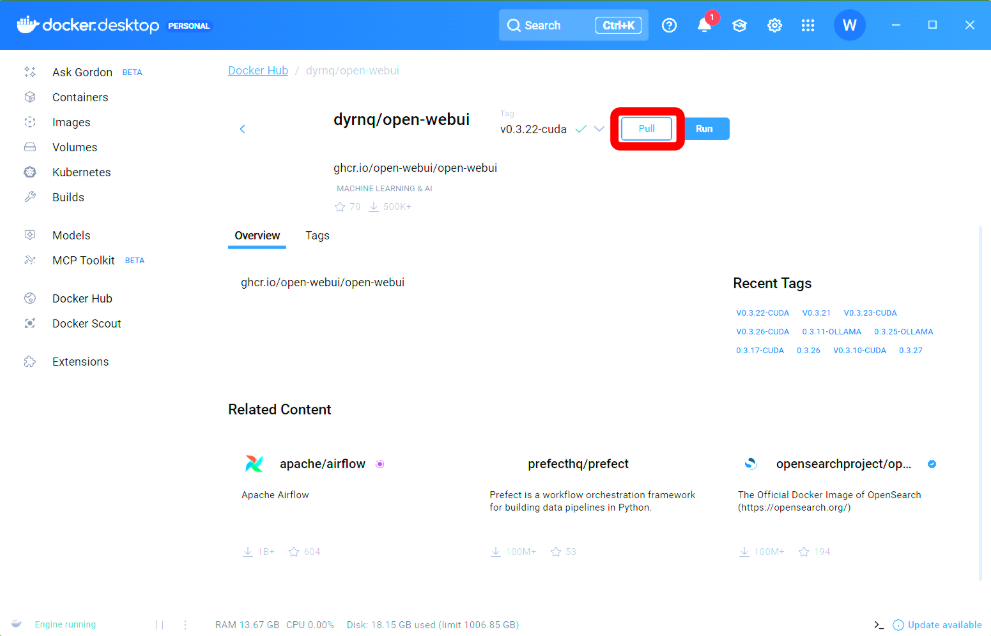

6.画面右上の「Pull」を選択

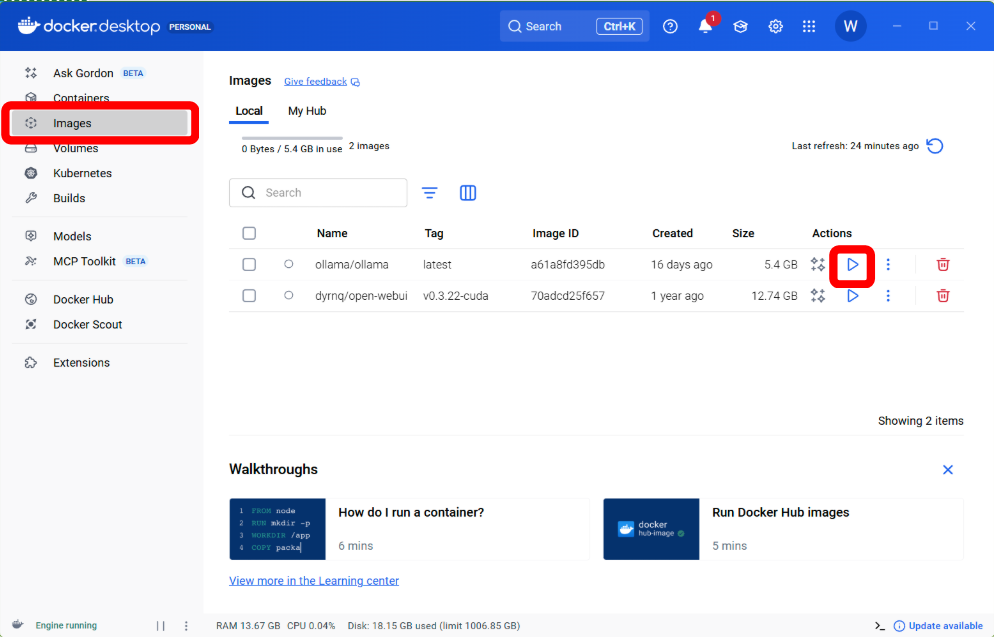

7.6が終わったら、

「Images」を選択しDockerHubでPullした2つがあることを確認します

「ollama/ollama」の右にある「▶」ボタンを押します。

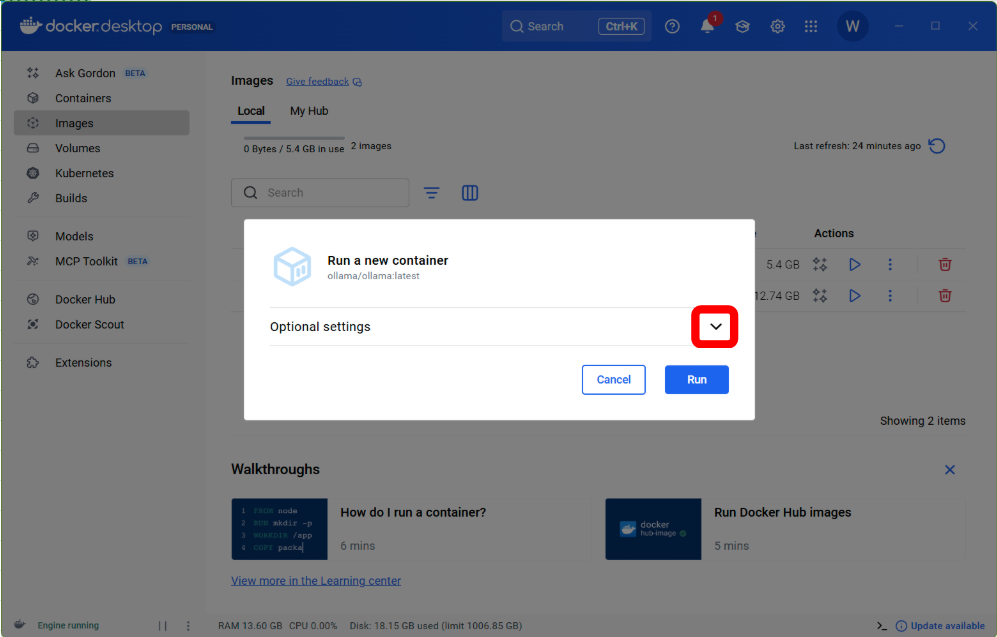

8.「∨」を押します

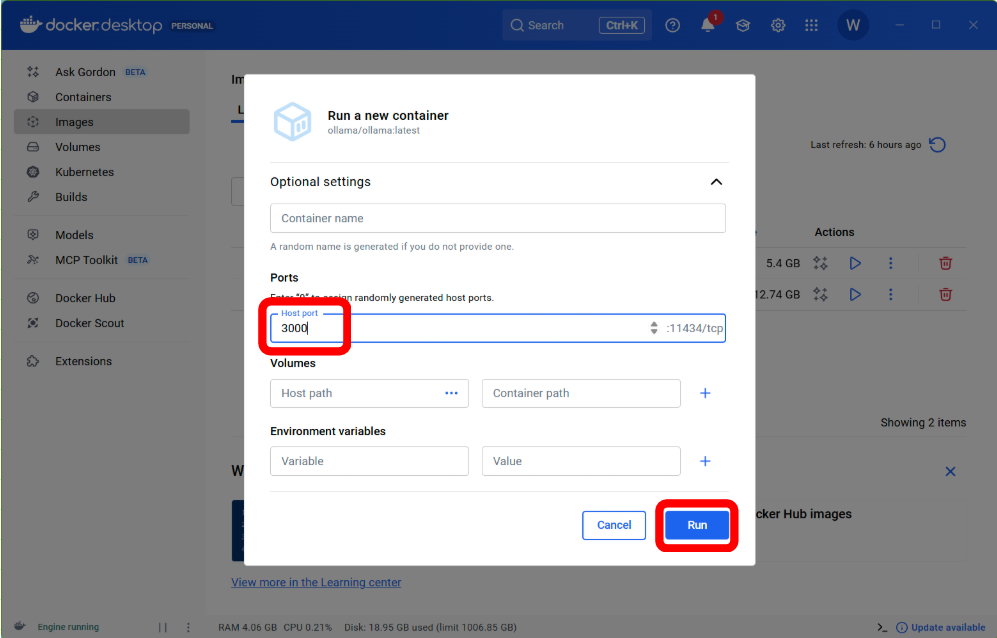

9.「Host port」に3000を入力

右下の「Run」を押します

※自分の環境に合わせてかぶらないポートにしてください。

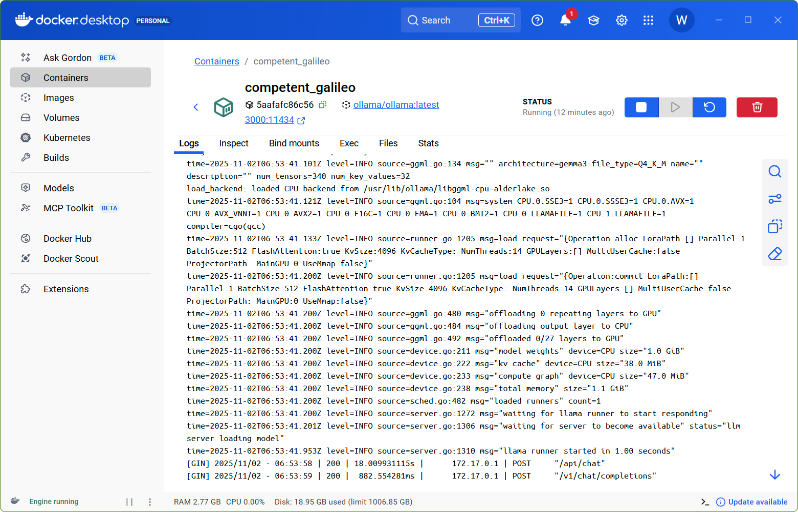

10.このような画面に切り替わればOK

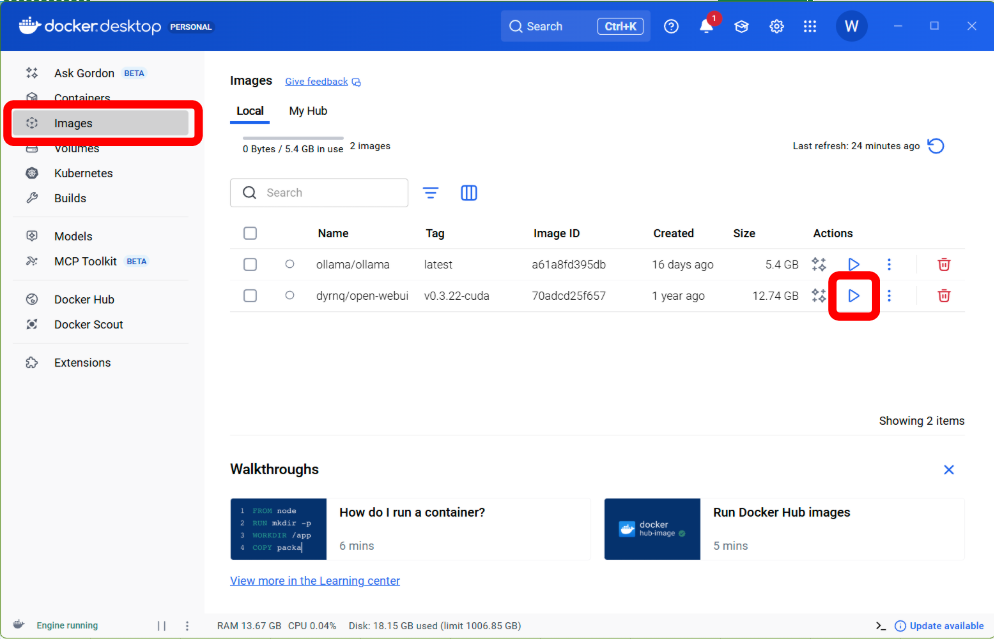

11.「Images」を選択します

「dyrnq/open-webui」の右にある「▶」ボタンを押します

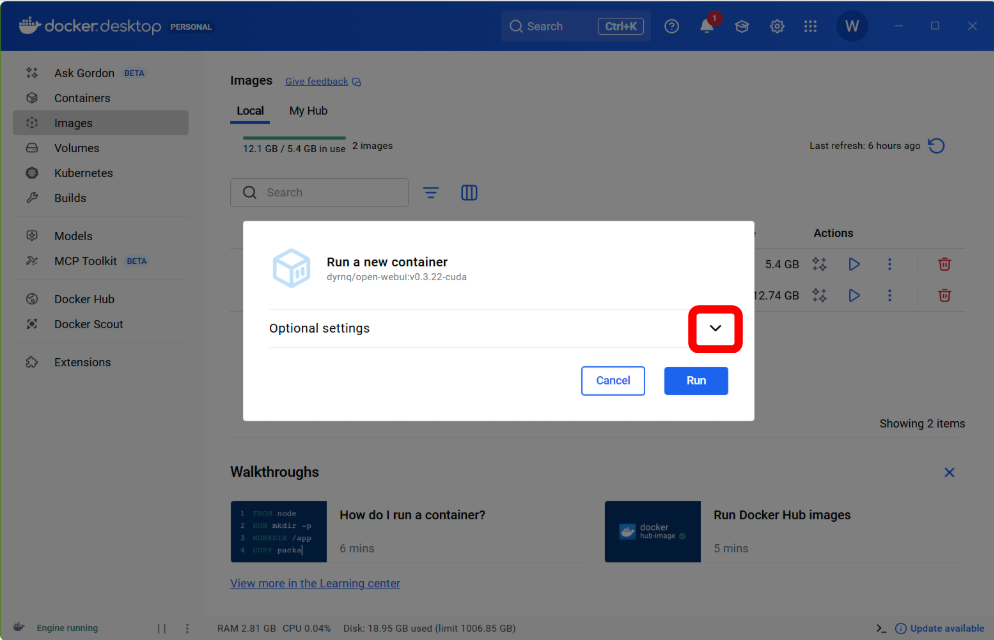

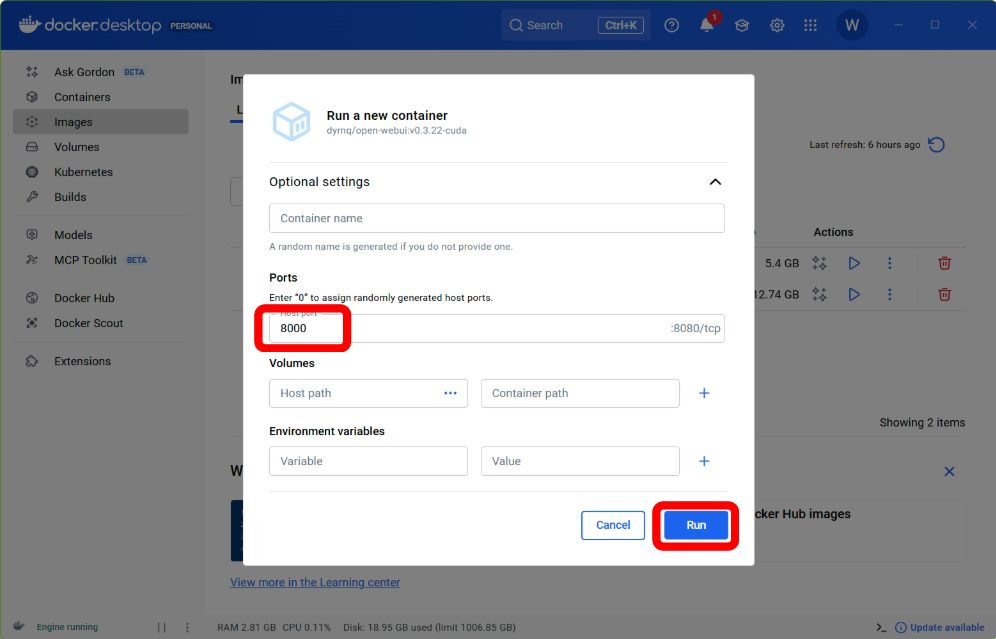

12.「∨」を押します

13.「Host port」に3000を入力

右下の「Run」を押します

※自分の環境に合わせてかぶらないポートにしてください。

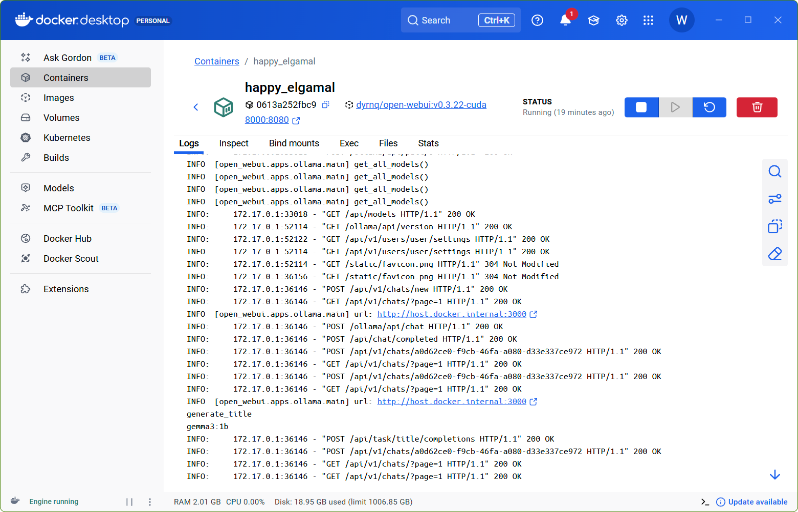

14.このような画面に切り替わればOK

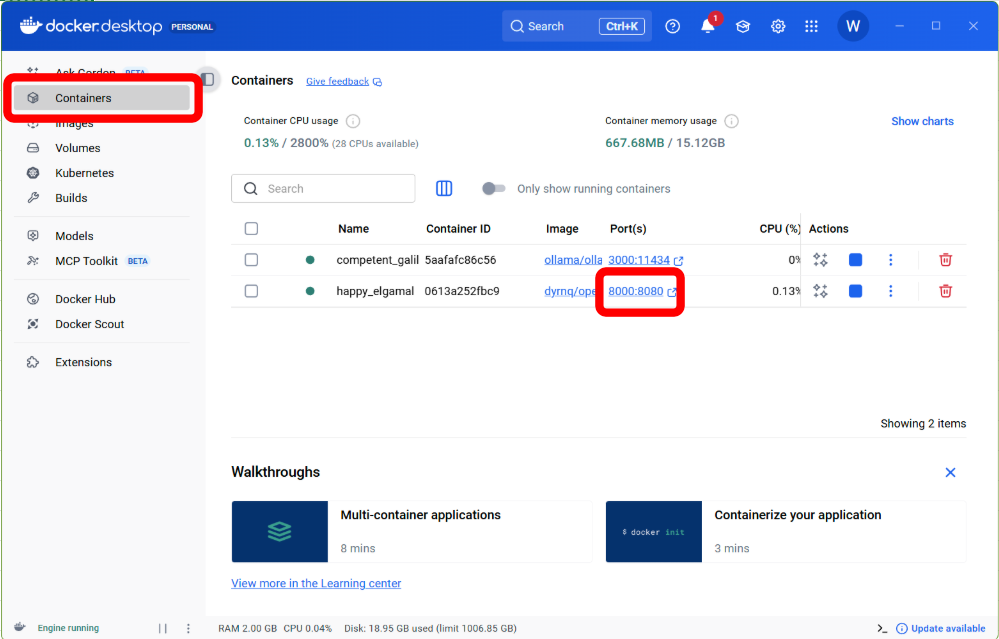

15.「Containers」を選択します

open-webuiで指定したポート「8000:8080」を押します

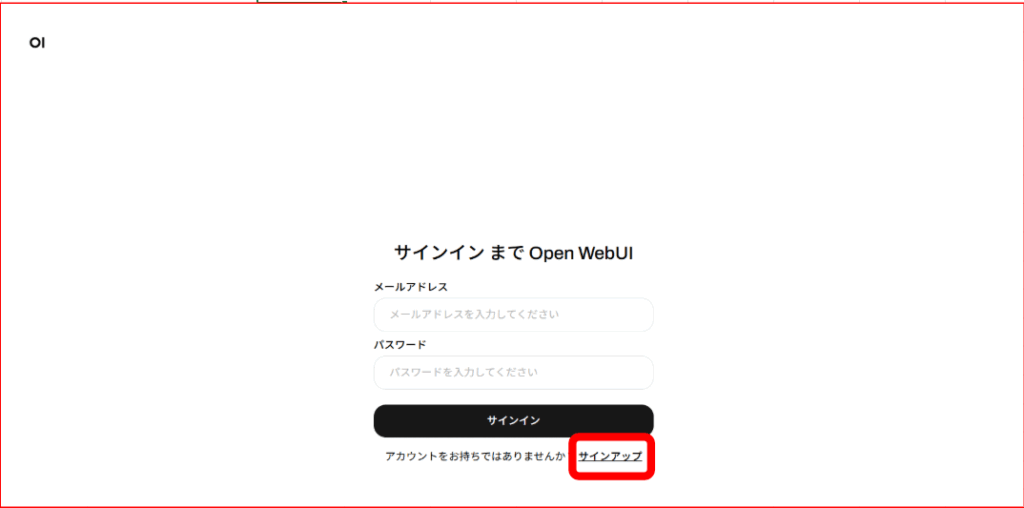

16.ブラウザが起動し下記のような画面が出ます。

「サインアップ」を押します。

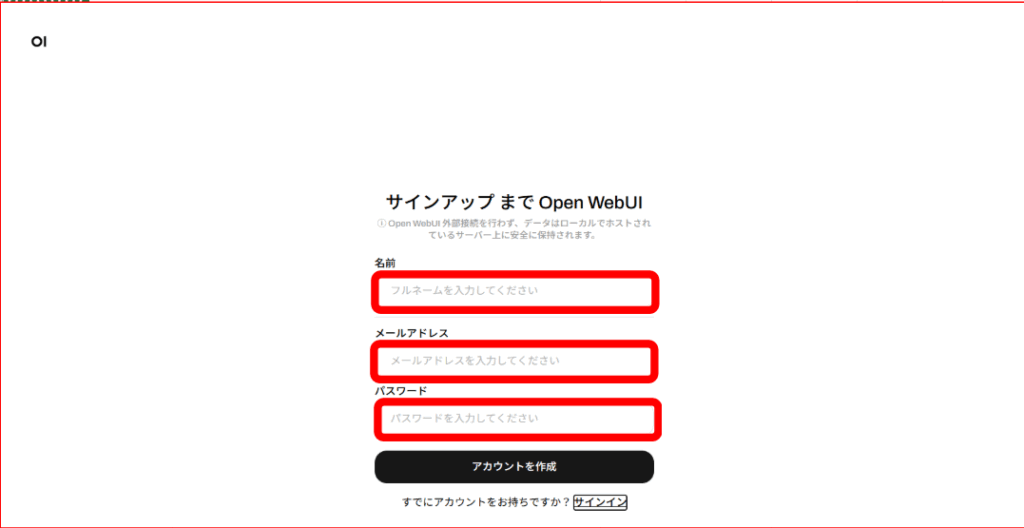

17.名前/メールアドレス/パスワードを入力し、アカウント作成を押します

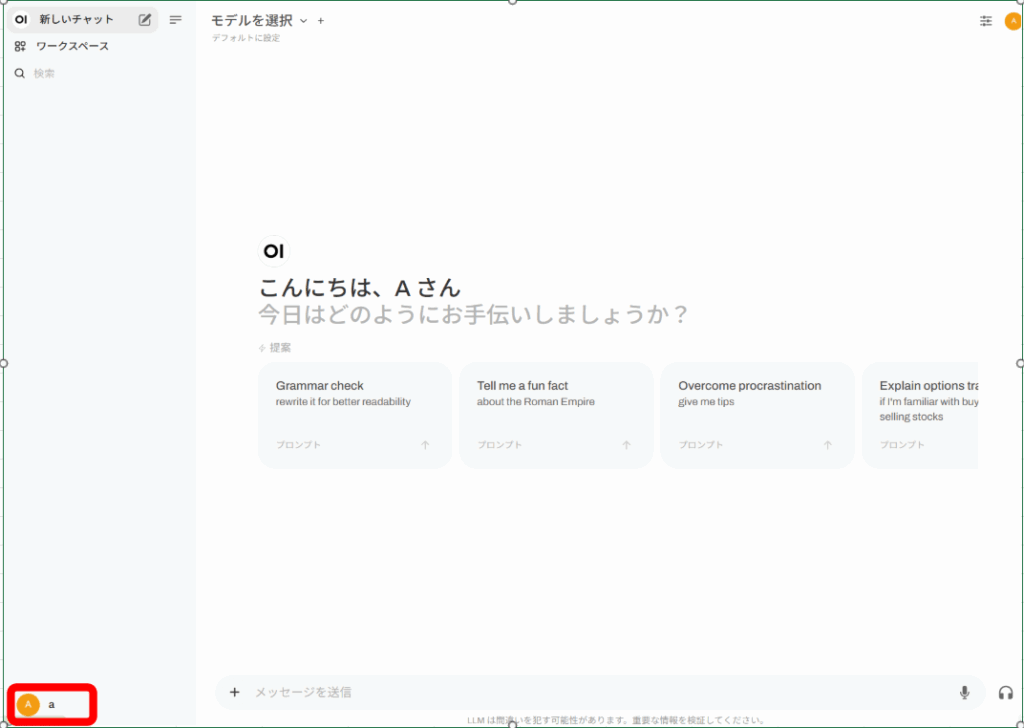

18.画面左下にある自分のカウアントのアイコンを押します。

19.メニューが出てきたら「管理者パネル」を選択します

20.画面上の「設定」を選択します

「接続」項目を選択します

「OpenAI API」の右にあるスイッチをOFFにします。

「Ollama API」にある「http://host.docker.internal:11434」の11434を「3000」に書き換えます。

右下の「保存」を押します

21.「モデル」項目を選択します

Ollama.com からモデルをプルに「gemma3:1b」を入力します

右側のアイコン「↓」を押します

※「ダウンロード可能なモデル名にアクセスするには、 ここをクリックしてください」にたくさんのモデルがあるのでお好きなものを選んでください。

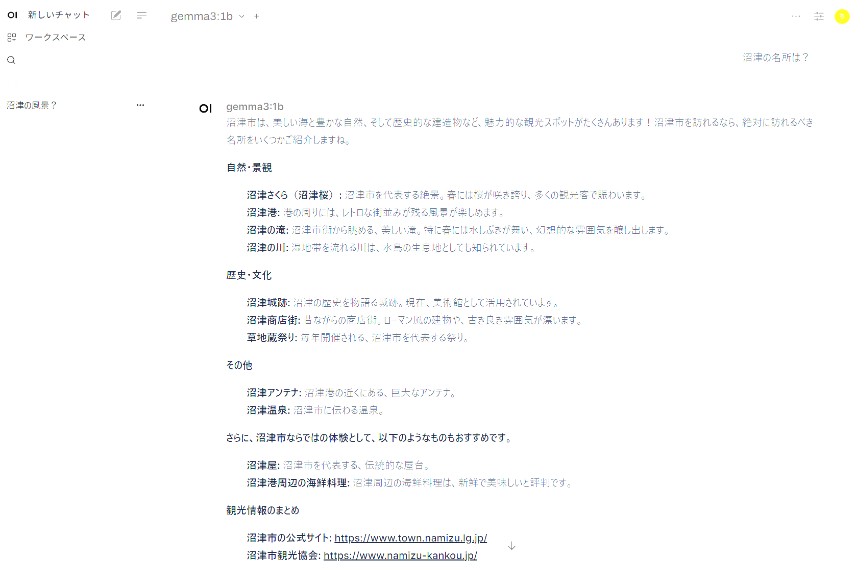

22.ダウンロードが終わったら

画面左上の「新しいチャット」を選択します

「モデルを選択」で20でダウンロードしたモデルを選択します

23.完成!

「メッセージ送信」にプロンプトをいれればOKです